Shaoqing Ren, Kaiming He, Ross Girshick, and Jian Sun

Abstract

이 모델에서는 full 이미지 convolutional feature와 detection 네트워크를 공유하는 Region Proposal Network (RPN)를 도입합니다. 즉, RPN은 fully convolutional network이고, 객체의 bound와 점수를 동시에 예측하게 됩니다.

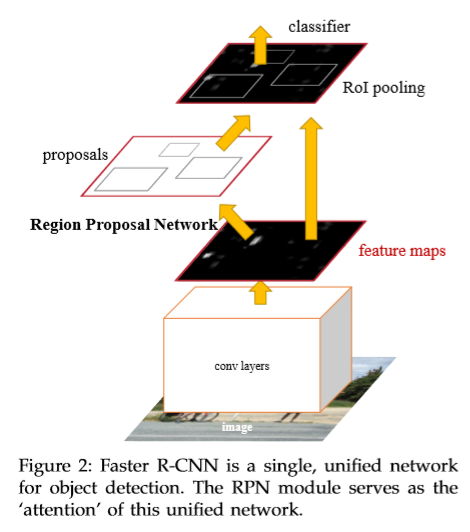

Faster R-CNN은 RPN과 Fast R-CNN을 하나의 네트워크로 합쳤습니다. 또한 Attention 메카니즘을 적용함으로써, RPN은 어디를 보아야 할지 알려주는 통합된 네트워크입니다. 그 결과 ILSVRC과 COCO 2015 competition에서 높은 정확도로 우승을 하게 되었습니다.

1. Introduction

2. Related Work

3. Faster R-CNN

Faster R-CNN은 두가지 모듈로 구성되어 있는데,

첫번째는 region을 제안하는 deep fully convolutional network이고,

두번째는 제안된 region을 사용하는 Fast R-CNN 디텍터입니다.

전체 시스템은 end-to-end 학습이 가능한 하나의 통합된 객체 탐색 네트워크입니다.

3.1 Region Proposal Networks

RPN은 입력으로 이미지를 받아서, 직사각형의 객체 proposals과 scores를 출력합니다.

또한 RPN은 Fully convolutional network로 되어있습니다.

공유된 마지막 convolutional 층에서 나온 feature map으로부터 작은 네트워크를 슬라이드합니다.

이 작은 네트워크는 n x n(3x3) 윈도우를 입력으로 취하고, 각 슬라이딩 윈도우는 작은 차원 특징에서 맵핑됩니다.

(256-d or 512-d)

마지막으로 이 특징(feature)은 fully connected layers를 거쳐서 box-regression layer(reg)와 box-classification layer(cls)에 도달하게 됩니다.

그림을 보시면 더 명확하게 이해할 수 있습니다.

3.1.1 Anchors

각 슬라이딩 윈도우마다 최대 k개의 region proposals을 예측합니다. 이 박스들을 anchor라고 부르기로 하고, 최대 k개의 앵커 박스는 중간 층을 거쳐서 2k개의 scores(객체인지, 객체가 아닌지)와 4k개의 바운딩 박스 좌표를 예측합니다.

앵커 박스의 개수는 scale과 aspect ratio에 의해 결정되는데, 이 논문에서는 3 scales, 3 aspect ratios를 이용했고, k=9의 결과를 만들어냅니다. 그래서 W x H 사이즈의 특징맵은 WHk 개의 앵커를 가지게 됩니다.

Translation-Invariant Anchors

파라미터 수: 3x3 x 512x512 + 512 x (4+2) x 9 = 2.4 x 10^6 로 Multibox 기법보다 적은 편입니다.

Multiple-scale Anchors as Regression References

Multiple-sclae 예측에는 두 가지 방법이 쓰입니다.

첫번째로)

이미지가 여러 스케일로 resize되고, 특징맵은 각 스케일에서 계산됩니다. 시간이 오래걸립니다.

두번째로)

특징맵에 슬라이딩 윈도우를 적용하는 것입니다.

여기서의 방법은 슬라이딩 윈도우와 여러 스케일의 리사이즈 방법 두가지를 적용하여 앵커의 피라미드를 지은 것과 같고, 비용이 효율적입니다.

이러한 앵커에 기반한 multi-scale 디자인을 통해, 다른 비용없이 특징맵을 공유할 수 있었습니다.

3.1.2 Loss Fuction

3.1.3 Training RPNs

RPN은 backpropagation과 SGD에 의한 end-to-end 학습이 가능합니다.

3.2 Sharing Features for RPN and Fast R-CNN

(i) Alternating training

(ii) Approximate joint training

(iii) Non-approximate joint training

3.3 Implementation Details

4. Experiments

4.1 Experiments on PASCAL VOC

4.2 Experiments on MS COCO

4.3 From MS COCO to PASCAL VOC

PASCAL 셋의 클래스는 20개 이므로, COCO 셋을 그에 맞게 20개만 추려내어 데이터를 더해서 학습을 진행하였습니다.

그 결과 mAP 성능이 73.2%에서 76.1%로 향상되었습니다.

또한 imageNet pretrained model 대신 COCO model을 사용하고, Faster R-CNN을 fine-tune하여 78.8%의 mAP를 얻어내었습니다.

5. Conclusion

효율적이고 정확한 region proposal 생성을 위해 RPN을 발표했습니다.

아래 디텍션 네트워크와 convolutional feature를 공유하여서 region propsal 단계는 거의 값 없이 진행했습니다.

통합된, 딥러닝 기반의 물체 탐색 시스템을 실시간 영상으로 구현할 수 있었습니다.

또한 RPN은 region proposal의 질을 높여 결국 전반적인 물체 탐색의 정확도를 높였습니다.

'ML, DL > 논문' 카테고리의 다른 글

| [GAN] Data Augmentation Using GANs, 2019 (0) | 2019.09.21 |

|---|---|

| Grad-CAM(Gradient-weighted Class Activation Mapping), 코드포함 (6) | 2019.08.08 |

| Cascade R-CNN, Cai et al, 2018 (0) | 2019.08.04 |

| [MMDetection] 논문 정리 및 모델 구현 (1) | 2019.07.28 |

| The Open Images Dataset V4, Kuznetsova, Google AI, 2018 (0) | 2019.07.18 |

댓글